Веб парсер

Парсинг данных с помощью веб парсера - один из самых важных и деликатных этапов любого проекта по веб-скрапингу, даже если мы не видим всего, что происходит за кулисами.

Что такое парсинг данных и веб парсер?

Что делает веб парсер - это преобразовывает последовательности (неструктурированных данных) в дерево или дерево парсинга (структурированные данные), которое легче читать, понимать и использовать. Этот процесс можно разделить на два этапа или компонента:

1) лексический анализ и

2) синтаксический анализ.

При лексическом анализе последовательность символов (неструктурированные данные) преобразуется в ряд лексем. Другими словами, парсер использует лексический анализатор, чтобы «превратить бессмысленную строку в „числовой литерал“, „строковый литерал“, „идентификатор“ или „оператор“, и может делать такие вещи, как распознавание зарезервированных идентификаторов (»ключевых слов«) и отбрасывание пробельных символов». Наконец, при синтаксическом анализе синтаксический анализатор берет эти лексемы и упорядочивает их в дерево парсинга, устанавливая элементы (узлы) и ветви (отношения между ними). Но ладно, это все еще очень абстрактная концепция, не так ли? Чтобы было проще понять, давайте рассмотрим, как веб парсер работает вместе с веб-скраппингом для извлечения нужной нам информации.

Парсинг данных и веб-скраппинг

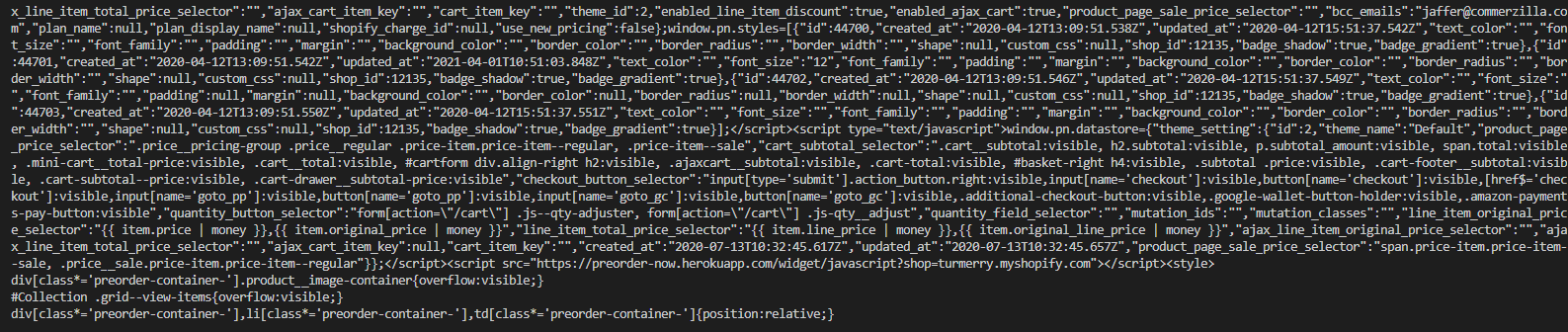

При написании веб-скрапера, неважно на каком языке, первое, что нам нужно сделать, - это получить доступ к информации на сайте, отправив запрос на сервер и загрузив необработанный HTML-файл. Эти HTML-данные практически не поддаются чтению.

Необработанные HTML данные

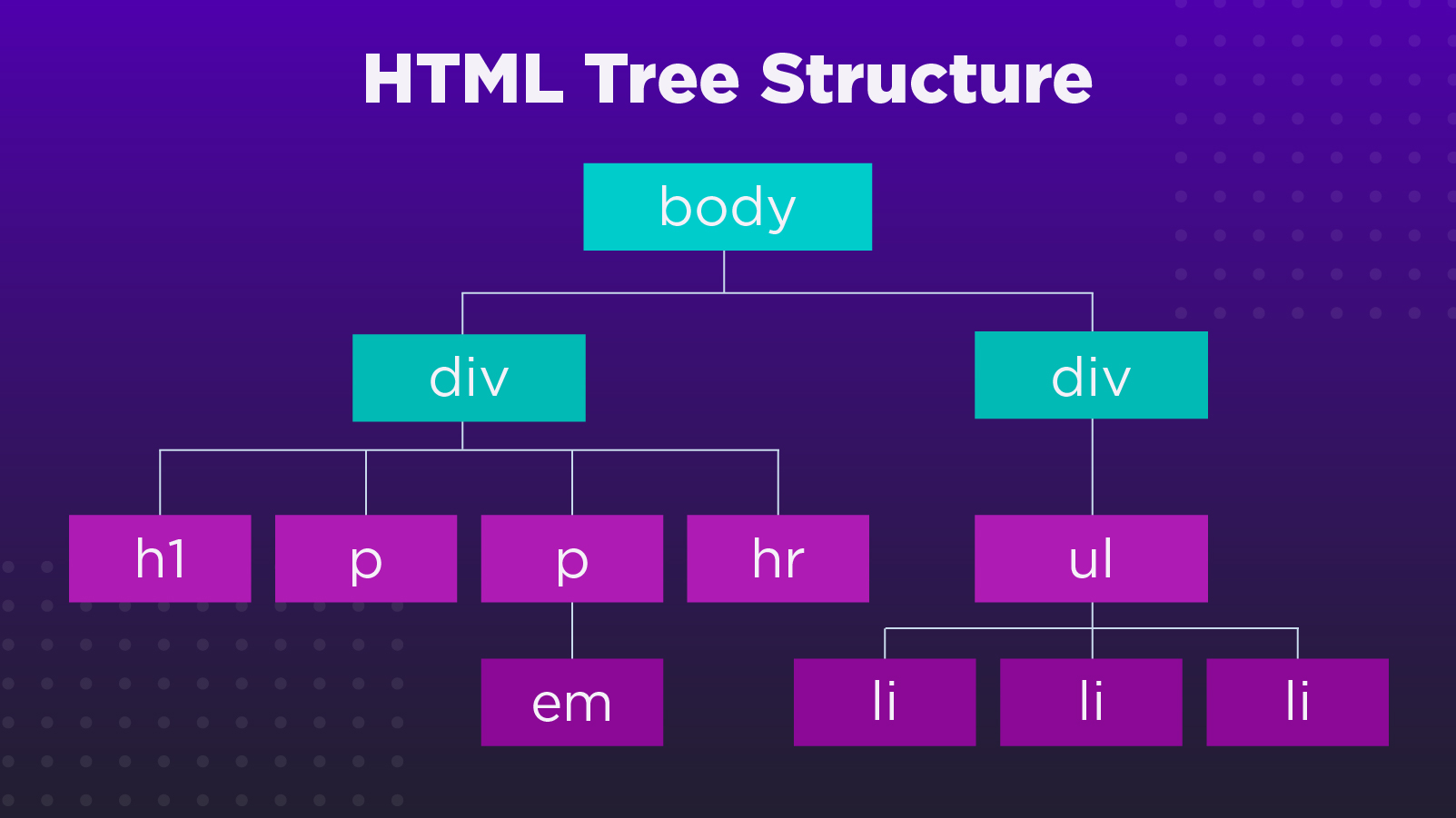

Чтобы вы и ваша команда могла использовать эти данные, нам нужно разобрать HTML и преобразовать его в дерево парсинга. Затем мы можем переходить к поиску конкретных фрагментов информации, которые имеют отношение к нашему бизнесу или целям.

Как видите, каждый узел представляет собой соответствующий HTML-элемент и его содержимое, а ветви - связи между ними. Другими словами, веб парсер очищает данные и упорядочивает их в структурированный формат, который содержит только то, что нам нужно, и теперь может быть экспортирован в JSON, CSV или любой другой формат, который мы определим. Самое приятное, что большая часть работы уже сделана за нас. В нашем распоряжении есть несколько веб парсеров и инструментов. В большинстве случаев они предоставляют множество ценных функций, таких как навигация по документу с помощью селекторов CSS или XPath в соответствии с их положением в дереве.

Лучшие библиотеки для парсинга и веб-скрапинга

Большинство данных, с которыми мы работаем в рамках веб-скрапинга, поступают в формате HTML. По этой причине существует множество библиотек для парсинга HTML с открытым исходным кодом, доступных практически для всех языков, которые вы можете себе представить. Это делает веб-скраппинг быстрее и проще. Вот некоторые из самых популярных библиотек парсинга, которые вы можете использовать в своих проектах:

Cheerio и Puppeteer

Для тех, кто знает JavaScript, Cheerio - это молниеносная библиотека Node-js, которая может быть использована для парсинга практически любого HTML- и XML-файла и «предоставляет API для обхода и управления полученной структурой данных». Однако если вам нужно делать скриншоты или выполнять JavaScript, лучше воспользоваться Puppeteer, инструментом автоматизации браузера, поскольку Cheerio не будет выполнять CSS или выполнять JS.

Beautiful Soup

Python, возможно, один из самых используемых языков в парсинге данных на сегодняшний день, и для него доступно множество отличных библиотек и фреймворков. Для веб-скрапинга Beautiful Soup - это отличный парсер, который может взять практически любой HTHML-файл и превратить его в дерево для парсинга. Самое приятное, что он обрабатывает кодировку за вас, так что он «преобразует входящие документы в Unicode, а исходящие - в UTF-8». Это делает экспорт данных в новые форматы еще более простым. Для более сложных проектов вам поможет Scrapy - фреймворк с открытым исходным кодом на языке Python, созданный специально для веб-скрапинга. С помощью Scrapy вы сможете написать сложные карулеры, которые будут ползать и извлекать структурированные данные практически с любого сайта. Самое лучшее в этом фреймворке то, что он поставляется с оболочкой (называется Scrapy Shell) для безопасного тестирования XPath и CSS-выражений без необходимости каждый раз создавать краулеров.

Rvest

Вдохновленный такими библиотеками, как Beautiful Soup, Rvest - это пакет, разработанный для упрощения задач веб-скреппинга в R. Он использует Magrittr для написания легко читаемых выражений (>), что ускоряет разработку и отладку. Чтобы еще больше расширить функциональность вашего скрипта, вы можете использовать Dplyr, чтобы использовать последовательный набор команд для управления данными, таких как select(), filter() и summarise(). Всего за три строки кода мы уже собрали все названия фильмов с сайта IMDB, так что вы можете представить себе весь потенциал этого пакета для ваших потребностей в веб-скраппинге.

Nokogiri

Имея более 300 миллионов загрузок, Nokogiri является одним из самых используемых драгоценных камней в веб-скраппинге на Ruby; особенно при парсинге форма HTML и XML. Благодаря популярности Ruby и активному сообществу, Nokogiri имеет много сообществ и учебников, что делает ее действительно доступной для новичков.

Как и другие библиотеки в этом списке, при веб-скраппинге с помощью Ruby вы можете использовать селекторы CSS и XPath для навигации по дереву парсинга и доступа к нужным данным. При этом скраппинг нескольких страниц с помощью Nokogiri довольно прост, если вы понимаете, как работает HTML.

HTMLAgilityPack

Для разработчиков на C# HTMLAgilityPack - это лучший парсер HTML и XML. Он работает быстро и обладает всеми необходимыми функциями для ваших проектов. Однако, возможно, вы захотите использовать его через ScrapySharp. ScrapySharp - это библиотека с открытым исходным кодом, написанная на языке c-sharp для веб парсинга. Она включает в себя веб-клиент для имитации браузера и расширение HTMLAgilityPack для использования CSS-селекторов при обходе дерева узлов.

ScraperAPI ScraperAPI, как вы уже догадались, - это API для веб-скрапинга, разработанный для того, чтобы помочь вам избежать блокировки по IP-адресу. Такие вещи, как ротация IP-адресов, рендеринг JavaScript и обработка CAPTCHA, автоматизированы для вас просто путем отправки ваших запросов через серверы ScraperAPI. Однако менее известным является то, что ScraperAPI также имеет функцию авторазбора. При установке autoparse=true в параметрах запроса, API будет разбирать сырой HTML и возвращать данные в формате JSON. В настоящее время этот функционал работает с Amazon, Google Search и Google Shopping. Чтобы получить 5000 бесплатных кредитов для API и собственный ключ API, зарегистрируйте бесплатный аккаунт ScraperAPI.

Стоит ли вам создавать собственный веб парсер?

Мы видели множество проектов, разработанных с помощью перечисленных выше инструментов, и сами пользовались ими, поэтому можем гарантировать, что вы сможете сделать практически все, что угодно, используя доступные библиотеки. Однако мы также знаем, что иногда (и для определенных отраслей) необходимо рассмотреть вариант создания собственного веб парсера. Если вы рассматриваете возможность создания собственного парсера, примите во внимание следующие плюсы и минусы, чтобы принять взвешенное решение:

Плюсы:

• Он может быть создан на любом языке программирования и полностью совместим с любыми инструментами или технологическим стеком, который вы уже используете.

• Создание собственного веб парсера может быть экономически эффективным, если у вас уже есть штатная команда разработчиков.

• Создав свой собственный веб парсер, вы получите полный контроль над тем, что и как парсится.

• Вы можете обновлять или изменять парсер в любое время.

Минусы:

• Ваш веб парсер нуждается в постоянном обслуживании, поэтому он может быстро превратиться в значительную статью расходов, если не является основным инструментом вашего бизнеса.

• Без штатной команды привлечение субподрядчиков может оказаться слишком дорогим, к тому же дополнительно будет необходимо провести их обучение.

• Для работы веб парсера вам потребуется создать и поддерживать серверы, которые должны быть достаточно быстрыми, чтобы справиться с объемом данных, которые вам нужно будет парсить.

• Дополнительной статьей расходов является кибербезопасность ваших серверов. В зависимости от того, насколько конфиденциальными являются данные, вам потребуется более высокий уровень защиты, чтобы избежать взлома.

В большинстве случаев вам будет достаточно использовать существующие технологии, но если с точки зрения бизнеса имеет смысл создать свой собственный веб парсер, то, возможно, стоит начать попробовав наш сервис PartScanner с 14-ти дневным бесплатным периодом.

Веб парсер: Подведение итогов

Парсинг крайне важен для обработки больших объёмов данных, поскольку мы не можем работать с необработанными данными - по крайней мере, эффективно и результативно. При этом еще важнее иметь в виду цель и понимать сайт, который мы пытаемся спарсить. Каждый сайт устроен по-своему, поэтому прежде чем писать код или выбирать необходимые инструменты, необходимо провести исследование. Сайты с большим количеством JS потребуют иного подхода, чем статические страницы, и не каждый инструмент может легко справиться с пагинацией. Помните, что веб-скрапинг - это изучение структуры сайта для извлечения нужных нам данных. Речь идет о решении проблем, а не только о техническом стеке.

Парсинг сайтов

- 43 готовых баз сайтов

- 12 валют для конвертации цен

- 27 функций замены данных

- 50 языков для перевода

- Гибкий планировщик

- Отправка на сайты по АПИ

- Выгрузка в csv,txt,xls,xlsx,xml

Чат

поддержки

Чат

поддержки